「AIとブラックボックス」設計・開発者の倫理と責任をどう考えるか?

AIが何故そのような解を出したかを、その設計者さえも分からない場合があります。

AIのディープラーニング(深層学習)の階層は、百階層、千階層と増えていき、その学習過程の複雑さが増し、解を得るためのプロセスが複雑化し、第三者から理解不能の部分、すなわちブラックボックスが増えていきます。

このブラックボックスに対しては、「なるべく分かるように見える化していこう」という考えと、「ブラックボックスとしてそのまま扱おう」という二つの対極的な考えがあります。

ブラックボックス化への道

かつて設計図面は、ドラフタと呼ばれる製図台で描かれ、製図過程において第三者が全貌や作業中の図を確認することができました。

その後、CADが導入されると、作業中の部分的な図は分かりますが、全貌は分からなくなりました。

第三者による中間品のチェックが困難になったわけです。

ソフトウェアの世界では、そのプログラム内容が複雑になった後、「他人の作成したプログラムの間違いを見つけることは不可能」と言われるようになりました。

それではどうやってプログラムの品質を確保したかというと、完成品ではなく、設計プロセスの確からしさを管理するという考えに至りました。

例えば「V字モデル」と呼ばれるもの用いる検証では、最初の設計プロセスである要求分析からコーディングまでのプロセスを分解し、各段階ごとに設計の確からしさを評価・検証していきます。

工程(作り方)の確からしさにより最終製品を保証するという考え方は、複雑な製品の場合も適用されます。

完成品の検査で全ての品質確認を行うことには限界があり、「品質に誤りの無いことは、完成品における代表値の検査と製造工程チェックの両方で行う」という考えを基本としています。

それではAIの場合はどうでしょうか?

AIが導き出した解という完成品と、解を導き出すプロセスの確からしさをどのように検証すれば良いでしょうか?

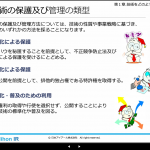

ブラックボックスとクリアボックス

製品の開発・製造において、一つのメーカーで全て行う場合と、製品を構成するモジュール、コンポーネント構成エレメントあるいは素材の開発・製造をサプライヤに発注する場合があります。

この際に、メーカーは、技術蓄積と問題発生時の技術対応力を高めるため、サプライヤからの調達品に対して、いわゆるクリアボックス化(ブラックボックス部分の低減)の努力を行います。

ただ、設計においても製造においても、サプライヤは、技術的を公開する代わりに独占排他権を得る「特許化」という方法以外に、「ノウハウ保持」と呼ばれる方法で技術非開示にするという方法をとることもあります。製品はこのような技術の集積ですから、完全なクリアボックス化はありえません。

一方、現在すでに共生しているスマートフォンを例にすると、もしノウハウ制限がなく、全て技術開示されるということが仮にあったとしても、その複雑な集積技術を全て完全に理解できる人はいません。

結局、複雑なシステムとは、大なり小なりブラックボックスを残して共生(使用)することしかできないということになります。

それでは、何故安心して色々な製品を使えるかというと、製品開発者の技術力に対する信頼ともに、開発者の倫理意識(正しいことを行うという意識)に対する信頼があるからです。

AIが学習できること

AIは、膨大な知識を完全コピーできますが、(*風が吹けば桶屋が儲かる的な複雑な因果関係も含み)AならばBという論理や推定、そして戦略も学習できます。

人間のなんとなくというような感情に関しても、複雑に絡み合ってはいますが原因・論理があります。

人間の感情や欲求の構造は複雑ですが、プルチックやマズローによる分類(感情32分類、欲求5段階)のように分解・分析が可能です。

Yさんが、ある絵を見て、「なんとなくもの悲しい感じだけど、心が休まるような感じがする」という意識には原因があります。AIが、Yさんの特性と絵の特性を分析し、同じ感想を答えとしてアウトプットできたならば、既にAIがYさんと同じ感情を持てていることになります。

感情理解は戦略と組み合わせることができます。

「空気を読んで行動する」(あるいは忖度する)というのは、素直な感情に対して戦略を加えて行動を制御しているものです。戦略は学習できます。「TPO(Time, Place, Occasion, 時と場所と状況)に応じて振る舞う」にも、感情理解を含めた原理・法則があるため、AI学習が可能です。

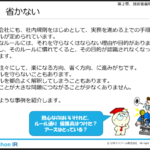

エンジニアには「エキスパートの倫理意識」が必要

倫理に反した、不正行為を行う原因としては、組織の目的を達成したい、名声を得たい、楽をしたい、欲望を満たしたいなどがありますが、これらの原因による不正を抑止するのが倫理意識です。

エンジニアなどのエキスパートは、ブラックボックスとなる深い専門知識を持っていますので、その活動においては、エンジニアとしての高い倫理意識が必要です。さらに社会や会社など組織の一員としての基本的倫理意識も必要です。

自立型AIロボットの倫理は?

深い知識と、広い知識、iTツールの自由自在な駆使、高いコミュニケーション能力、そして他者を信頼して任せられる力をもって、複雑で大きなミッションを達成できるようなスーパーエンジニアは、極少数です。

一方、将来AIロボットが、ひとたびそのレベルに達したならば、複製でいくらでも数を増やすことが可能です。それらはネットワークで繋がり、自己強化学習をシェアし、継続的な進歩ができます。

そのような時代では、AIロボットは、自律型から自立型に進化していると思いますが、このときに重要になるのが倫理意識です。AIロボットには、エキスパートエンジニアと同様に高い倫理意識が必要です。

必要というより、人との共生のためには無くては危険と言った方が良いかもしれません。

子供を、ひとに思いやりのある自立した大人に育てるのは親の責務ですが、AIロボットに倫理意識を学習させるのは開発者の責務です。

倫理意識というのは、漠然としていて難しい概念です。

まずは開発者が倫理意識というものについて学んでおかなければなりません。

*風が吹けば桶屋が儲かる(突拍子もない江戸時代のお話):

(風がよく吹く)→(よくゴミが舞い目に入る)→(盲目の人が増える)

→(盲目の人が三味線引きになる)→(三味線が多く必要になる)

→(三味線に使うネコの皮が多く必要になる)→(ネコが獲られて減る)

→(ネズミが増える)→(ネズミが桶をかじる)→(新しい桶が必要になる)

→(桶屋が儲かる)

(アイアール技術者教育研究所 H・N)